AI Act: l’Ue Approva il Primo Regolamento al Mondo sull’Intelligenza Artificiale

L’AI Act rappresenta un passo fondamentale verso la regolamentazione di questa tecnologia, contribuendo a creare un ambiente digitale più sicuro e etico per tutti.

Dall’industria manifatturiera all’assistenza sanitaria, dalla mobilità alla finanza, l’IA si è affermata come una forza propulsiva della trasformazione digitale. L’automazione di processi complessi, l’analisi di dati voluminosi e l’ottimizzazione di sistemi preesistenti sono solo alcuni esempi del suo impatto dirompente.

Questa rapida evoluzione ha reso sempre più necessaria ed urgente una regolamentazione di questa tecnologia che, per sua natura (cioè la capacità di prendere decisioni e auto-apprendere), porta con sé implicazioni etiche importanti e delicate.

Da aprile 2021 l’UE sta quindi lavorando al cosiddetto AI Act, un primo quadro normativo armonizzato sull’Artificial Intelligence, che è stato approvato dal Parlamento europeo il 13 marzo 2024. Il regolamento deve ancora essere sottoposto alla verifica finale dei giuristi-linguisti e dovrebbe essere adottato definitivamente prima della fine della legislatura. Inoltre, la legge deve ancora essere formalmente approvata dal Consiglio. Entrerà in vigore venti giorni dopo la pubblicazione nella Gazzetta ufficiale dell’UE e inizierà ad applicarsi 24 mesi dopo l’entrata in vigore.

L’AI Act si basa sul principio che l’IA deve essere sviluppata e utilizzata in modo sicuro, etico e rispettoso dei diritti fondamentali e dei valori europei, garantendo il controllo umano, la sicurezza, la privacy, la trasparenza, la non discriminazione e il benessere sociale e ambientale. Le applicazioni di AI, infatti, stanno raggiungendo capacità di analisi sempre maggiori e possono “decidere” quali azioni intraprendere sulla base dei dati a disposizione. Ma se un’applicazione di AI prende una decisione sbagliata o che privilegia ingiustamente o danneggia un essere umano, di chi sarà la responsabilità? Ecco perché, con il diffondersi di questa tecnologia, l’UE ha deciso di lavorare a quello che sarà il primo regolamento sull’AI al mondo.

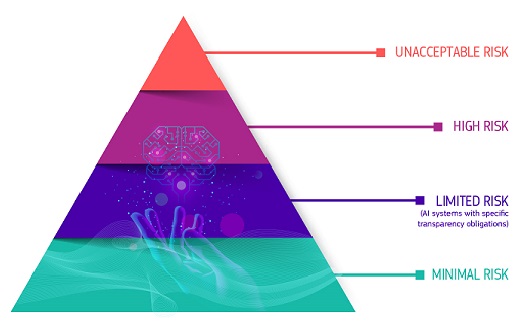

L’intelligenza artificiale può trasformare profondamente la società e l’economia, ma allo stesso tempo può anche presentare dei rischi per i diritti, la sicurezza e il buon funzionamento del mercato unico. Per trovare un equilibrio tra le due istanze – accompagnare l’Europa nell’adozione dell’IA e dei suoi benefici e farlo per l’interesse generale – l’AI Act è stato pensato con un approccio basato sul rischio.

Il quadro normativo sull’IA prevede quindi una classificazione dei sistemi di IA in base al livello di rischio che presentano per le persone e per la società e stabilisce una serie di requisiti e obblighi per i fornitori e gli utenti di tali sistemi. Il quadro distingue tra quattro categorie di rischio: inaccettabile, alto, limitato e minimo.

Rischio inaccettabile

I sistemi di IA che presentano un rischio inaccettabile sono quelli che contraddicono i valori e i principi fondamentali dell’UE, come il rispetto della dignità umana, della democrazia e dello stato di diritto. Questi sistemi sono vietati o soggetti a severe restrizioni. Nello specifico, sono proibiti i sistemi di categorizzazione biometrica basati su caratteristiche sensibili e l’estrapolazione indiscriminata di immagini facciali da internet o dalle registrazioni dei sistemi di telecamere a circuito chiuso per creare banche dati di riconoscimento facciale. Sono vietati anche i sistemi di riconoscimento delle emozioni sul luogo di lavoro e nelle scuole, i sistemi di scoring sociale, le pratiche di polizia predittiva (se basate esclusivamente sulla profilazione o sulla valutazione delle caratteristiche di una persona) e i sistemi che manipolano il comportamento umano o sfruttano le vulnerabilità delle persone, come ad esempio i giocattoli che utilizzano l’assistenza vocale per incoraggiare comportamenti pericolosi.

Rischio alto

I sistemi di IA che presentano un rischio elevato sono quelli che possono avere un impatto “sistemico”, ossia significativo sui diritti fondamentali o sulla sicurezza delle persone. Rientrano in questa categoria i sistemi di IA utilizzati per la selezione e il reclutamento del personale, per l’ammissione all’istruzione, per l’erogazione di servizi sociali essenziali, come la Sanità, per la sorveglianza biometrica a distanza (non in tempo reale), per le applicazioni giudiziarie e di polizia, o per la gestione della sicurezza critica delle infrastrutture

Questi sistemi sono soggetti a rigorosi obblighi e requisiti prima di poter essere immessi sul mercato o utilizzati, salvo alcune eccezioni rigorosamente definite e regolamentate, ad esempio quando necessarie per la ricerca di un minore scomparso, per prevenire una minaccia terroristica specifica e imminente o per individuare, identificare o perseguire un autore o sospettato di un reato grave. Tali usi sono soggetti all’autorizzazione di un organo giudiziario o di altro organo indipendente e a limiti di tempo, di portata geografica e di ricerca delle banche dati.

Rischio limitato

I sistemi di IA che presentano un rischio limitato sono quelli che possono influenzare i diritti o le volontà degli utenti, ma in misura minore rispetto ai sistemi ad alto rischio. Ad esempio, rientrano in questa categoria i sistemi di IA utilizzati per generare o manipolare contenuti audiovisivi (come i deepfake), o per fornire suggerimenti personalizzati (come le chatbot). Questi sistemi sono soggetti a requisiti di trasparenza, che consentono agli utenti di essere consapevoli del fatto che interagiscono con un sistema di IA e di comprenderne le caratteristiche e le limitazioni. Ad esempio, un individuo che interagisce con un chatbot deve essere informato che sta interagendo con una macchina in modo da poter decidere se procedere o richiedere di parlare con un essere umano.

Rischio minimo

I sistemi di IA che presentano un rischio minimo o nullo sono quelli che non hanno alcun impatto diretto sui diritti fondamentali o sulla sicurezza delle persone, e che offrono ampi margini di scelta e controllo agli utenti. Questi sistemi sono liberi da qualsiasi obbligo normativo, al fine di incoraggiare l’innovazione e la sperimentazione. Ad esempio, rientrano in questa categoria i sistemi di IA utilizzati per scopi ludici (come i videogiochi) o per scopi puramente estetici (come i filtri fotografici).

L’AI Act prevede un sistema di sanzioni in caso di violazione delle disposizioni previste. Le sanzioni possono variare a seconda della gravità e della natura dell’infrazione, e sono proporzionate alla dimensione e al fatturato dell’operatore economico responsabile. Le sanzioni possono includere:

La regolamentazione delle applicazioni di intelligenza artificiale rappresenta un passo fondamentale verso un utilizzo responsabile e sicuro di questa potente tecnologia, per plasmare un futuro in cui l’intelligenza artificiale sia un alleato affidabile e rispettoso dei valori umani, contribuendo a creare un ambiente digitale più sicuro e etico per tutti. La chiave sta nell’equilibrio tra l’innovazione tecnologica e la protezione dei diritti umani, un obiettivo che richiede un impegno costante da parte di tutti gli attori coinvolti.

Fonte: a cura della Redazione di Exportiamo, redazione@exportiamo.it

© RIPRODUZIONE RISERVATA